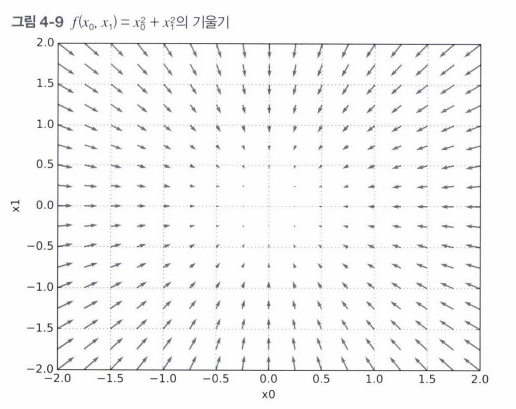

밑바닥부터 시작하는 딥러닝 4단원 - 신경망 학습 p 108 - 146 더보기 학습이란? 훈련 데이터로부터 가중치 매개변수의 최적값을 자동으로 획득하는 것 신경망이 학습할 수 있도록 해주는 지표 → 손실함수 목표 : 손실 함수의 결과값을 가장 작게 만드는 가중치 매개변수를 찾는 것 ! 손실 함수의 값을 가급적 작게 만드는 기법으로 함수의 기울기를 활용함 신경망의 특징은 데이터를 보고 학습할 수 있다는 점이다. = 가중치 매개변수의 값을 데이터를 보고 자동으로 결정한다 1. 데이터 주도 학습 기계학습은 데이터가 생명이다 ! 어떤 문제를 해결하려고 할 때, 패턴을 찾아내야 할 때 사람의 경험과 직관을 단서로 시행착오를 거듭하며 일을 진행한다. 반면 기계학습에서는 사람의 개입을 최소화하고 수집한 데이터로부터 ..