반응형

SMALL

▷ 밑바닥부터 시작하는 딥러닝 p 78 - 106

1 ) 다차원 배열

넘파이의 다차원 배열을 사용하면 신경망을 효율적으로 구현할 수 있다

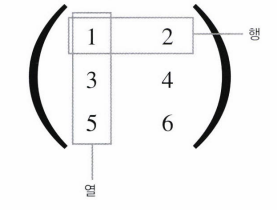

「 3 × 2 배열 」

0번째 차원 - 원소 3개

1번째 차원 - 원소 2개

1 행렬의 곱

두 행렬의 곱 계산

Y = np.dot(A,B)2 신경망에서의 행렬의 곱

2 ) 3층 신경망 구현

핵심: 신경망에서의 계산을 행렬 계산으로 정리할 수 있다

표기법

<<출력층의 활성화 함수(시그마) >>

- 회귀: 항등 함수

- 2클래스 분류: 시그모이드 함수

- 다중 클래스 분류: 소프트맥스 함수

3 ) 출력층 설계

기계학습 문제는 분류와 회귀로 나뉜다

- 분류: 데이터가 어느 클래스(class)에 속하는지

- 회귀: 입력 데이터에서 (연속적인) 수치를 예측

- 출력층에서 사용하는 활성화 함수가 달라진다

- 일반적으로 회귀에는 항등 함수를, 분류에는 소프트맥스 함수를 사용함

※ 항등 함수: 입력을 그대로 출력

출력층의 뉴런 수 정하기

소프트맥스 함수 softmax function

분류에서 사용하는 활성화 함수

※ 소프트맥스 함수 구현 시 주의점

오버플로 문제

컴퓨터는 표현할 수 있는 수의 범위가 한정되어 너무 큰 값은 표현할 수 없다는 문제가 발생한다

▶ 소프트맥스 함수의 출력

- 0 ~1 사이의 실수

- 출력 총합 = 1

- 소프트맥스 함수의 출력을 확률로 해석할 수 있음

▶ 손글씨 숫자 인식

추론 과정 : 순전파 forward propagation

배치 처리

분류 - 출력층의 뉴런 수를 분류하려는 클래스 수와 같게 설정

배치: 입력 데이터를 묶은 것

추론 처리를 이 배치 단위로 진행하면 결과를 훨씬 빠르게 얻을 수 있음

반응형

LIST

'[Deep Learning] 딥러닝 기초' 카테고리의 다른 글

| DL study - 신경망 학습 (0) | 2024.01.23 |

|---|---|

| DL 스터디 - 신경망 & 활성화 함수 (0) | 2024.01.16 |

| DL 스터디 - 퍼셉트론 (2) | 2024.01.09 |