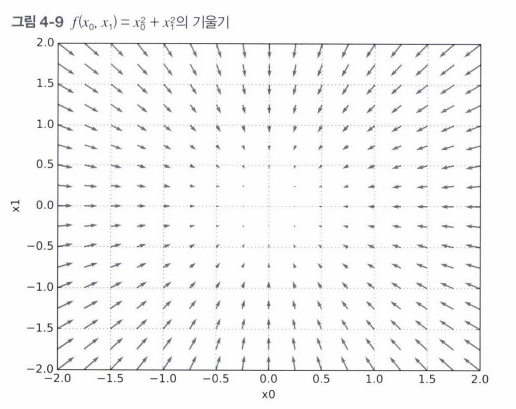

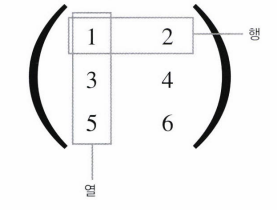

밑바닥부터 시작하는 딥러닝 5단원 - 오차역전파법 p 148 - 187 신경망의 가중치 매개변수의 기울기 -> 수치 미분을 사용하여 구현함 수치 미분은 단순하고 구현하기도 쉽지만 계산 시간이 오래 걸린다는 것이 단점 따라서 가중치 매개변수의 기울기를 효율적으로 계산하는 '오차역전파법'에 대해 학습해보자. 오차역전파법 : 오차를 역으로 전파하는 방법 (Backward propagation of errors) 계산 그래프 (computational graph) 국소적 계산 각 노드는 자신과 관련한 계산 외에는 아무것도 신경 쓸 게 없다 전체 계산이 아무리 복잡하더라도 각 단계의 국소적인 계산은 단순함. 계산 그래프의 이점 ? 1. 국소적 계산 2. 중간 계산 결과를 모두 보관 가능 3. 역전파를 통해 '미분..